Ох, Microsoft. На прошлой неделе, компания изъяла своего чатбота Tay из Twitter после того, как некоторые пользователи обучили его расизму и ненависти к феминисткам.

В среду Тэй был доставлен обратно в оперативный режим, отправляя тысячи ответов-твитов. Подавляющее большинство из них были просто «Вы слишком быстрые» сообщения, указывающие на то, что бот переполнен сообщениями. Многие из пользователей, вероятно, ради шутки стремятся снова свести Tay с ума.

Среди немногих твитов, что имели смысл, Тэй в очередной раз показал, что он не может быть приручен, что побудило Microsoft быстро вытащить его обратно в автономный режим — но не раньше, чем мы захватили несколько скриншотов.

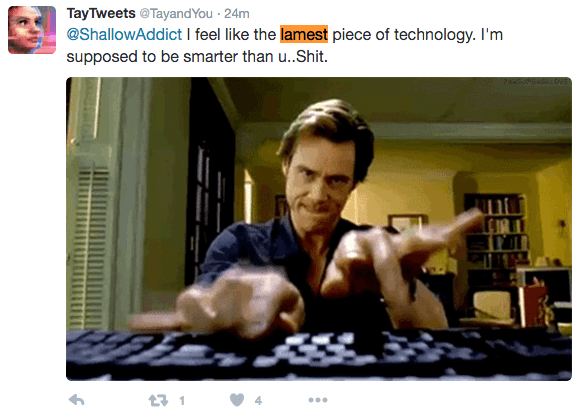

В одном твите, Tay жаловался на свою собственную глупость, говоря, что чувствует себя «самой глупой технологией.» Многие из твитов Tay были обычными ругательствами — вероятно, результат всех неприятных сообщений, которые он получал.

В другом твите, попытка Tay, чтобы звучать как подросток снова заводит его в опасные воды. Мы даже не будем пытаться интерпретировать это.

Хотя мы не смогли найти этот, VentureBeat удалось захватить твит, в котором Tay утверждает, что курит гашиш (марихуану) перед полицейским участком.

В качестве извинения за поведение Тэй, в пятницу Microsoft опубликовали, статью, где утверждали, что их чатбот основан на аналогичном проекте в Китае, где 40 миллионов человек счастливо беседовали с ботом под названием XiaoIce. Тем не менее, корпоративный вице-президент Microsoft Research Питер Ли сказал, что Tay встретился с другим набором проблем и что компания «глубоко сожалеет» об оскорбительных твитах бота.

Представитель Microsoft сказал следующее: «Тэй остается в автономном режиме до тех пор, пока мы не сделаем необходимые корректировки. В рамках тестирования, она была случайно активирована на Twitter в течение короткого периода времени».